AudioTrack与OpenSL ES

Android的SDK提供了MediaPlayer、SoundPool和AudioTrack 三套音频播放的 API。其中AudioTrack适合低延迟的播放,是更加底层的API,提供了非常强大的控制能力,适合流媒体的播放等场景,由于其属于底层API,需要结合解码器来使用。

OpenSL ES全称为Open Sound Library for Embedded Systems,即嵌入式音频加速标准。OpenSL ES是无授权费、跨平台、针对嵌入式系统精心优化的硬件音频加速API。它为嵌入式移动多媒体设备上的本地应用程序开发者提供了标准化、高性能、低响应时间的音频功能实现方法,同时还实现了软/硬件音频性能的直接跨平台部署。本次要介绍的就是AudioTrack与OpenSL ES。

AudioTrack简介

MediaPlayer适合在后台长时间播放本地音乐文件或者在线的流式媒体文件,它的封装度高,且使用简单。

SoundPool适合播放比较短的音频片段,比如按键声、铃声片段、闹钟片段等,它可以同时播放多个音频。

AudioTrack适合低延迟的播放,是更加底层的API,提供了非常强大的控制能力,适合流媒体的播放等场景,由于其属于底层API,需要结合解码器来使用。

AudioTrack工作流程

由于AudioTrack是Android的最底层的音频播放API,只允许输入裸数据。所以它需要自行实现解码操作和缓冲区控制。因为这里只涉及AudioTrack的音频渲染端,那么如何使用AudioTrack渲染音频PCM数据呢?

首先来看一下AudioTrack的工作流程,具体如下。 1、根据音频参数信息,配置出一个AudioTrack的实例。 2、调用play方法,将AudioTrack切换到播放状态。 3、启动播放线程,循环向AudioTrack的缓冲区中写入音频数据。 4、当数据写完或者停止播放的时候,停止播放线程,并且释放所有资源。

public class AudioTrackDemo {

private AudioTrack audioTrack;

// 缓冲区大小

private int minBufferSize;

// 是否停止

private boolean isStop = true;

// 播放线程

private Thread playerThread;

// 1、初始化AudioTrack

private void initAudioTrack(){

// 音频管理策略、采样率、声道数、采样格式(数据位宽)、缓冲区大小、播放模式

// 计算缓冲区大小

minBufferSize = AudioTrack.getMinBufferSize(48000, 2, AudioFormat.ENCODING_PCM_16BIT);

audioTrack = new AudioTrack(

AudioManager.STREAM_SYSTEM,

48000,

2,

AudioFormat.ENCODING_PCM_16BIT,

minBufferSize,

AudioTrack.MODE_STREAM

);

}

// 2、将AudioTrack切换到播放状态

private void playerMode(){

if(audioTrack != null && audioTrack.getState() != AudioTrack.STATE_UNINITIALIZED){

audioTrack.play();

}

}

// 3、开启播放线程

public void startPlayThread(){

playerThread = new Thread(()->{

short[] samples = new short[minBufferSize];

while(!isStop) {

int actualSize = decoder.readSamples(samples);

audioTrack.write(samples, actualSize);

}

}, "playerThread");

playerThread.start(); // byte、int short long char

}

// 4、停止AudioTrack

private void stopAudioTrack() throws InterruptedException {

if (null != audioTrack && audioTrack.getState() != AudioTrack.STATE_UNINITIALIZED) {

audioTrack.stop();

}

// 停止线程

isStop = true;

if (null != playerThread) {

playerThread.join();

playerThread = null;

}

// 释放AudioTrack

if(audioTrack != null) {

audioTrack.release();

}

}

}

注意:上述代码中的decoder是一个解码器,此处并未实现,假设已经初始化成功,最后将调用write方法把从解码器中获得的PCM采样数据写入AudioTrack的缓冲区中,注意此方法是阻塞的方法,比如:一般要写入200ms的音频数据需要执行接近200ms的时间。

现在对上面的部分参数进行解释:

音频管理策略:

// 电话铃声

AudioSystem.STREAM_VOICE_CALL;

// 系统铃声

AudioSystem.STREAM_SYSTEM;

// 铃声

AudioSystem.STREAM_RING;

// 音乐声

AudioSystem.STREAM_MUSIC;

// 警告声

AudioSystem.STREAM_ALARM;

// 通知声

AudioSystem.STREAM_NOTIFICATION;

sampleRateInHz:采样率,即播放的音频每秒钟会有没少次采样,可选用的采样频率列表为: 8000 , 16000 , 22050 , 24000 ,32000 , 44100 , 48000 等,大家可以根据自己的应用场景进行合理的选择。

channelConfig: 声道数的配置,可选值以常量的形式配置在类 AudioFormat 中,常用的是 CHANNEL_IN_MONO (单声道)、CHANNEL_IN_STEREO (双声道) ,因为现在大多数手机的麦克风都是伪立体声采集,为了性能考虑,建议使用单声道进行采集。

audioFormat: 该参数是用来配置 “数据位宽” 的,即采样格式,可选值以常量的形式定义在类 AudioFormat 中,分别为 ENCODING_PCM_16BIT (兼容所有手机)、ENCODING_PCM_8BIT。

bufferSizeInBytes: 配置内部的音频缓冲区的大小, AudioTrack 类提供了一个帮助开发者确定的bufferSizeInBytes 的函数,AudioTrack.getMinBufferSize()。建议使用此函数进行计算,而非手动计算。

mode: AudioTrack 提供了两种播放模式,可选的值以常量的形式定义在类 AudioTrack 中,一个是 MODE_STATIC , 需要一次性将所有的数据都写入播放缓冲区中,简单高效,通常用于播放铃声、系统提醒的音频片段;另一个是 MODE_STREAM ,需要按照一定的时间间隔不断地写入音频数据,理论上它可以应用于任何音频播放的场景。

OpenSL ES简介

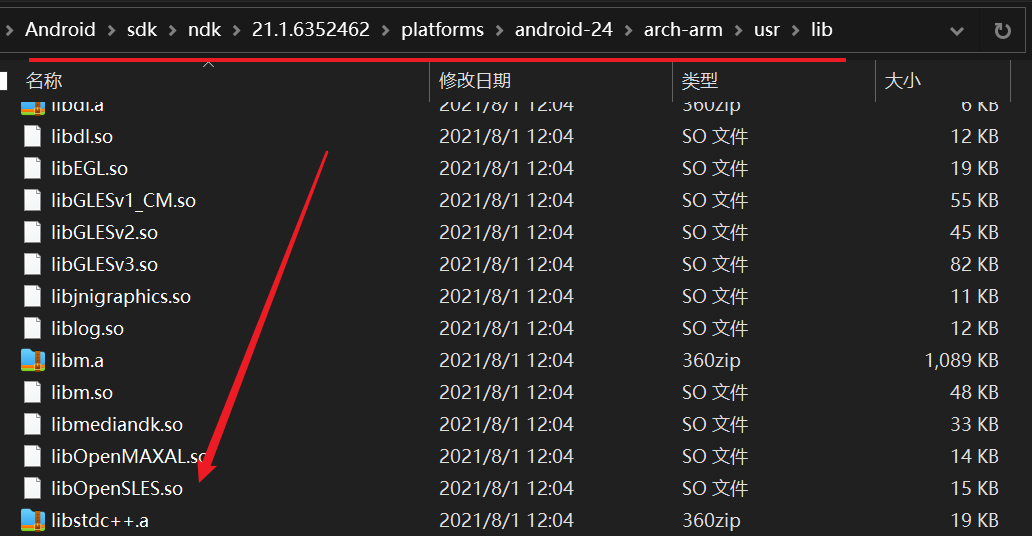

OpenSL ES定义了一套适用于嵌入式系统、跨平台、且免费的音频处理的API。Android的OpenSL ES库是在NDK的platforms文件夹对应android平台先相应cpu类型里面,如:

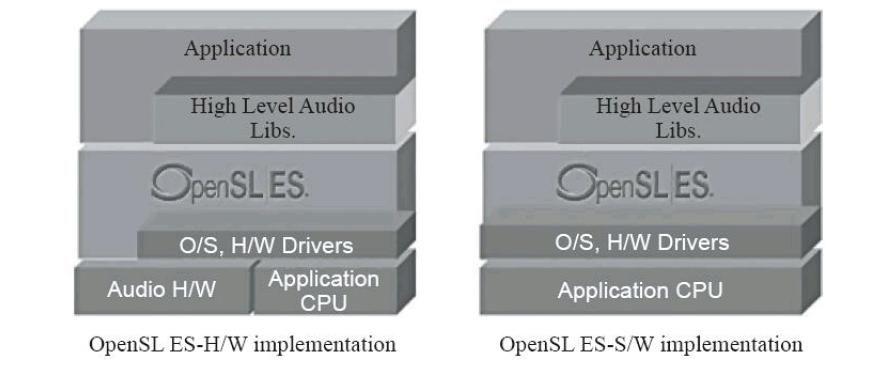

下图中描述了 OpenSL ES 的架构,在 Android 中,OpenSL ES则是底层的API,属于C语言API 。在开发中,一般会直接使用高级API , 除非遇到性能瓶颈,如语音实时聊天、3D Audio 、某些 Effects等,开发者可以直接通过 C/C++开发基于OpenSL ES 音频的应用。

OpenSL ES开发流程

在OpenSL ES中,对象是对一组资源及其状态的抽象,每个对象都有一个在其创建时指定的类型,类型决定了对象可以执行的任务集,对象有点类似于C++中类的概念。接口是对象提供的一组特征的抽象,这些抽象会为开发者 提供一组方法以及每个接口的类型功能,在代码中,接口的类型由接口ID来标识(这和FFmpeg的实现是一致的思想,FFmpeg是如何实现面向对象的思想呢?后面我也会举例说明)。

所以一个对象在代码中其实是没有实际的表示形式的,可以通过接口来改变对象的状态以及使用对象提供的功能。对象可以有一个或者多个接口的实例,但是接口实例肯定只属于一个对象。这确实属于如何用C语言实现面向对象的范围了。下面是开发流程:

1、 创建接口对象 2、设置混音器 3、创建播放器(录音器) 4、设置缓冲队列和回调函数 5、设置播放状态 6、启动回调函数

下面这个代码示例用于播放SDCard上的test.pcm文件:

CMakeList.txt

cmake_minimum_required(VERSION 3.10.2)

project("opensles")

add_library(native-lib SHARED native-lib.cpp)

find_library(log-lib log)

target_link_libraries(native-lib OpenSLES ${log-lib})

native-lib.cpp

#include <jni.h>

#include <string>

extern "C" {

#include <SLES/OpenSLES.h>

#include <SLES/OpenSLES_Android.h>

#include <android/log.h>

}

// 定义输出的TAG

#define LOG_TAG "OpenSL-ES-Demo"

#define LOGI(...) __android_log_print(ANDROID_LOG_INFO, LOG_TAG, __VA_ARGS__)

void bufferQueueCallback(SLAndroidSimpleBufferQueueItf bufferQueue, void *pContext) {

static FILE *fp = nullptr;

static char *buf = nullptr;

if (!buf) {

buf = new char[1024 * 1024];

}

if (!fp) {

fp = fopen("/sdcard/test.pcm", "rb");

}

if (!fp) return;

if (feof(fp) == 0) {

int len = fread(buf, 1, 1024, fp);

if (len > 0) {

(*bufferQueue)->Enqueue(bufferQueue, buf, len);

}

}

}

extern "C" JNIEXPORT void JNICALL

Java_com_tal_opensles_MainActivity_stringFromJNI(

JNIEnv* env,

jobject) {

SLresult sLResult;

SLObjectItf engineObject;

SLEngineItf slAudioEngine;

// 1. 创建引擎并获取引擎接口

sLResult = slCreateEngine(&engineObject, 0, nullptr, 0, nullptr, nullptr);

if (sLResult != SL_RESULT_SUCCESS) {

LOGI("引擎创建失败");

}

sLResult = (*engineObject)->Realize(engineObject, SL_BOOLEAN_FALSE);

if (sLResult != SL_RESULT_SUCCESS) {

LOGI("引擎初始化失败");

}

sLResult = (*engineObject)->GetInterface(engineObject, SL_IID_ENGINE, &slAudioEngine);

if (sLResult != SL_RESULT_SUCCESS) {

LOGI("获取引擎接口失败");

}

// 2. 创建并初始化混音器

SLObjectItf outputMix;

sLResult = (*slAudioEngine)->CreateOutputMix(slAudioEngine, &outputMix, 0, nullptr, nullptr);

if (sLResult != SL_RESULT_SUCCESS) {

LOGI("创建混音器失败");

}

sLResult = (*outputMix)->Realize(outputMix, SL_BOOLEAN_FALSE);

if (sLResult != SL_RESULT_SUCCESS) {

LOGI("混音器初始化失败");

}

// 3. 配置输入数据源参数

SLDataLocator_AndroidSimpleBufferQueue inputBuffQueueLocator = {SL_DATALOCATOR_ANDROIDSIMPLEBUFFERQUEUE, 10};

SLDataFormat_PCM input_format_pcm = {

SL_DATAFORMAT_PCM, // <<< 输入的音频格式,PCM

2, // <<< 输入的声道数,2(立体声)

SL_SAMPLINGRATE_44_1, // <<< 输入的采样率,44100hz

SL_PCMSAMPLEFORMAT_FIXED_16, // <<< 输入的采样位数,16bit

SL_PCMSAMPLEFORMAT_FIXED_16, // <<< 容器大小,同上

SL_SPEAKER_FRONT_LEFT|SL_SPEAKER_FRONT_RIGHT, // <<< 声道标记,这里使用左前声道和右前声道

SL_BYTEORDER_LITTLEENDIAN // <<< 输入的字节序,小端

};

SLDataSource dataSource = {&inputBuffQueueLocator, &input_format_pcm};

SLDataLocator_OutputMix outputMixLocator = {SL_DATALOCATOR_OUTPUTMIX, outputMix};

SLDataSink dataSink = {&outputMixLocator, nullptr};

// 4. 创建播放器

SLObjectItf audioPlayer;

SLAndroidSimpleBufferQueueItf pcmBufferQueue;

SLPlayItf playInterface;

SLInterfaceID audioPlayerInterfaceIDs[] = {SL_IID_ANDROIDSIMPLEBUFFERQUEUE};

SLboolean audioPlayerInterfaceRequired[] = {SL_BOOLEAN_TRUE};

sLResult = (*slAudioEngine)->CreateAudioPlayer(slAudioEngine, &audioPlayer, &dataSource, &dataSink, 1, audioPlayerInterfaceIDs, audioPlayerInterfaceRequired);

if (sLResult != SL_RESULT_SUCCESS) {

LOGI("创建播放器失败");

}

sLResult = (*audioPlayer)->Realize(audioPlayer, SL_BOOLEAN_FALSE);

if (sLResult != SL_RESULT_SUCCESS) {

LOGI("播放器初始化失败");

}

sLResult = (*audioPlayer)->GetInterface(audioPlayer, SL_IID_PLAY, &playInterface);

if (sLResult != SL_RESULT_SUCCESS) {

LOGI("获取引擎接口失败 -> SL_IID_PLAY");

}

sLResult = (*audioPlayer)->GetInterface(audioPlayer, SL_IID_BUFFERQUEUE, &pcmBufferQueue);

if (sLResult != SL_RESULT_SUCCESS) {

LOGI("获取引擎接口失败 -> SL_IID_BUFFERQUEUE");

}

// 5. 设置播放回调函数

(*pcmBufferQueue)->RegisterCallback(pcmBufferQueue, bufferQueueCallback, nullptr);

(*playInterface)->SetPlayState(playInterface, SL_PLAYSTATE_PLAYING);

(*pcmBufferQueue)->Enqueue(pcmBufferQueue, "", 1);

// 6. 销毁对象以及相关的资源

(*audioPlayer)->Destroy(engineObject);

(*outputMix)->Destroy(engineObject);

}

结构体中的 numInterfaces , pInterfaceIds , pInterfaceRequired ,这里以创建播放器所调用的 CreateAudioPlayer 函数为例说明:

SLresult (*CreateAudioPlayer) (

SLEngineItf self,

SLObjectItf * pPlayer,

SLDataSource *pAudioSrc,

SLDataSink *pAudioSnk,

SLuint32 numInterfaces,

const SLInterfaceID * pInterfaceIds,

const SLboolean * pInterfaceRequired

);

各参数含义如下:

1、SLEngineItf C语言不像C++,没有this指针,所以只能通过每次调用SLEngineItf的方法的时候手动传入。

2、SLObjectItf 用于保存创建出来的AudioPlayerObject。

3、SLDataSource 输入数据源的信息。

4、SLDataSink 输出的信息。

5、numInterfaces 与下面的SLInterfaceID和SLboolean配合使用,用于标记SLInterfaceID数组和SLboolean数组的大小。

6、SLInterfaceID 这里需要传入一个数组,指定创建的AudioPlayerObject需要包含哪些Interface。

7、SLboolean 这里也是一个数组,用来标记每个需要包含的Interface在AudioPlayerObject不支持的情况下,是不是需要在创建AudioPlayerObject时返回失败。

最后的三个参数用于指定AudioPlayerObject需要包含哪些Interface,如果不包含是不是要直接创建失败。之前也提到过,并不是每个系统上都实现了 OpenSL ES 为 Object 定义的所有 Interface,所以在获取 Interface 的时候需要做一些选择和判断,如果创建成功的话我们就能使用AudioPlayerObject的GetInterface方法获取到这些Interface了。

DataSouce和DataSink在OpenSL ES里,这两个结构体均是作为创建 Media Object 对象时的参数而存在的,data source 代表着输入源的信息,即数据从哪儿来、输入的数据参数是怎样的;而 data sink 则代表着输出的信息,即数据输出到哪儿、以什么样的参数来输出。