Vue中如何渲染Markdown和JSON

最近开发OpenAI提供的Assistant功能,其中有个插件叫做Code Interpreter,由于需要把Assistant的分析过程在Vue中展示一下,方便问题定位,所以Code Interpreter生成的代码肯定也是要展示的,其他过程几乎都是Markdown的格式,所以特此记录下在Vue中如何渲染Markdown,在其他场景也会经常遇到渲染Markdown的需求。

最近开发OpenAI提供的Assistant功能,其中有个插件叫做Code Interpreter,由于需要把Assistant的分析过程在Vue中展示一下,方便问题定位,所以Code Interpreter生成的代码肯定也是要展示的,其他过程几乎都是Markdown的格式,所以特此记录下在Vue中如何渲染Markdown,在其他场景也会经常遇到渲染Markdown的需求。

随着AI大模型技术的快速发展,其实从今年5月份开始,我也越发觉得LLM在企业中的应用越来越广泛,因此我也开始学习LLM,本文是一些LLM相关的学习笔记,主要记录了LLM的发展历程、应用场景、基本的技术原理等,另外本篇还侧重于介绍NLP中一些常见的概念,这样能快速的切入到大模型的学习中。

OpenAI在2020年5月发布了GPT-3的论文,而在2022年2月1日,GPT3.5也随之问世。国内对大模型的热情似乎从22年的12月开始高涨。对我个人而言,从我首次打开GPT3.5的对话页面到现在,已经过去了九个月。在此,我想分享一下我对大模型的一些想法。

在本节中将继续探讨CNN的核心概念以及一些经典的CNN框架(LeNet、AlexNet、VGG16等),以更好地理解这一强大的图像处理工具。卷积神经网络是一种深度学习模型,广泛应用于图像识别和处理任务。CNN通过卷积层、池化层和全连接层等结构,能够有效提取图像中的特征信息,从而实现分类、检测等任务。

在深度学习的探索旅程中,我们从模拟人类神经网络结构的多层感知器(MLP)开始,逐步探索了非线性预测的实现。通过逻辑回归模型的组合,构建了能够处理复杂预测任务的庞大网络。通过实践我们了解了MLP在图像识别任务中的应用,特别是在处理MNIST数据集时的有效性。但是,面对更高分辨率的图像,MLP模型的局限性就显现出来,因为所需的参数数量巨大,导致计算量大增。为解决这一问题,引入了卷积神经网络(CNN)。

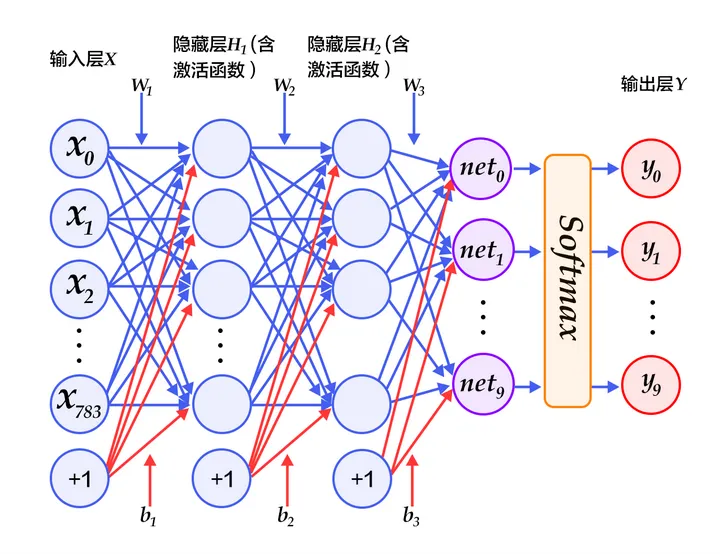

通过MLP实现手写数字识别是一个经典案例,mnist 是keras自带的一个用于手写数字识别的数据集,它的图像的分辨率是 $28 * 28$,也就是有784个像素点,它的训练集是60000个手写体图片及对应标签,测试集是10000个手写体图片及对应标签。本例中:输入层784个单元,两个隐藏层都是392个神经元,最后输出层10个单元:

之前主要学习了常见的机器学习算法,现在开始进入另一个环节:深度学习。首先就是多层感知机模型,Multi-Layer Perception(简称MLP)是标准的全连接神经网络模型,它由节点层组成,其中每个节点连接到上一层的所有输出,每个节点的输出连接到下一层节点的所有输入。本节会从一个简单的分类任务开始,逐步探讨多层感知机的工作原理。

通过酶活性预测实战来体验体验模型从欠拟合到过拟合、再到拟合的过程。选择模型从线性回归 -> 多项式回归。通过进行异常检测,帮助找到了潜在的异常数据点,进行主成分分析,判断是否需要降低数据维度,然后通过数据分离,即使未提供测试样本,也能从训练数据中分离出测试数据。然后计算得到混淆矩阵,实现模型更全面的评估。最后通过调整KNN核心参数让模型在训练数据和测试数据上均得到了好的表现。